Data Lakehouse Nedir?

2021-02-18 Büşra Güner

Data Lake mi demek istiyorsun?

Hayır.

Data Warehouse mu?

Hayır hayır!

Lakehouse!

Her şeyin en başından başlayalım, gel!

Data Warehouse!

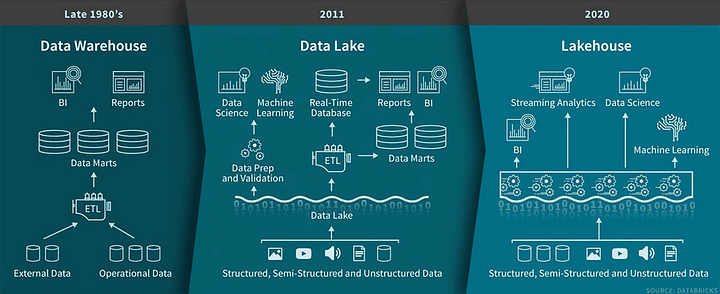

Veri analitik dünyasında geçmişten gelen ilişkisel verilerin olduğu, ETL’ler ile veri dönüşümleri veya veri temizlikleri yaptığımız, çoğunlukla farklı kaynaklardan beslenen sistemlerdir. Veri ambarlarını var olan soruların cevaplarını bulmak ve karar süreçlerini desteklemek için kullanırız.

Bildiğimiz gibi iş zekası uygulamasında veri ambarları oldukça uzun bir geçmişe sahip ve 1980'lerden beri bu teknoloji gelişmeye devam ediyor. Bu gelişmeler MPP (Massively Parallel Processing) mimarileri ve daha büyük boyutlu verileri işleyebilen sistemleri doğurdu. Dolayısıyla biriken bu tecrübe ile sistemi, ihtiyaçları ve nasıl yapılması gerektiğini artık çok iyi biliyoruz.

Ancak veri ambarları structured yani yapılandırılmış veriler için iyi bir çözüm olsa da bir çok büyük işletme artık unstructured, yapılandırılmamış ya da yarı yapılandırılmış verilerle çalışmak zorundalar. Özellikle Big Data kavramlarına yakınsayan çeşitliliği, hızı ve hacmi yüksek verilerdir. Bildiğimiz gibi Big Data Data Lake’ lerin, Hadoop’ ların devreye girdiği, verilerin structured olmadığı bir dünya. IOT cihazlarından ve sosyal medya platformlarından akan veriler gibi temel örnekleri var. Veri ambarları ise bu durumda ne kullanım için ne de maliyet anlamında uygun değiller.

Data Lake!

Bu durumda şirketler büyük veriyi toplamaya başladıkça, farklı analitik ürünleri ve iş yüklerini barındıracak tek bir sistem tasarlamaya başladılar ve bu da veri göllerini ortaya çıkardı. Ancak buradaki sorun veri göllerinin transaction akışını desteklememesi , veri kalitesi ve tutarlılığı konusundaki eksiklikleri oldu. Üstelik Data Warehouse ve Data Lake dediğimiz iki dünyanın ihtiyaçları elbette birbirinden farklı. Biri tamamen kontrolümüzde iken diğeri deneysel çalışma yapılması gereken bir alan olarak karşımıza çıkıyor.

Bu sebeple de teknoloji geliştiren Microsoft gibi firmalar esnek ve yüksek performanslı sistemler geliştirmeye yöneldiler.

Raporlama, gerçek zamanlı veri, veri bilimi ve makine öğrenimi gibi çalışmaların hepsini içinde barındıracak sistemler üzerine çalışılmaya başlandı.

DataBricks bu mimari ortamın aslında öncüsü diyebiliriz. Microsoft’un Azure DataBricks ile entegre olan Azure Synapse Analytics hizmeti de benzer bir Lakehouse modeli oldu böylelikle.

Data Lakehouse!

Peki Lakehouse nedir, nereden çıktı? Durduramadığımız bu teknoloji çağının gelişim hızında bizi nereye götürmeye geldi?

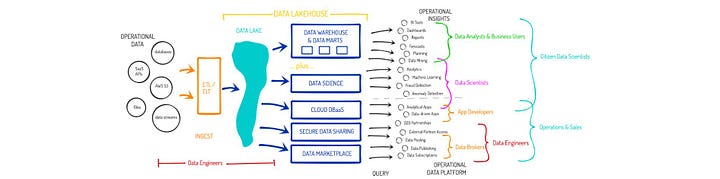

Data Lakehouse işte tam da veri ambarı ve veri gölü dediğimiz iki farklı yapıyı birleştiren bir veri çözümü konseptidir. Veri ambarlarında kullandığımız veri yapılarını ve daha uygun maliyetli olan veri göllerinin özelliklerini entegre ederek doğmuştur. Bu yaklaşım, veri ambarını oluşturan ETL / ELT süreçlerini ortadan kaldırıyor ve böylece Query Engine doğrudan veri gölünden sorgulama yapıyor. Bu da operasyonel maliyette yüksek oranda tasarruf sağlayacak bir teknoloji ortaya çıkarıyor.

Ortaya çıkmasındaki önemli unsurlardan biri ise gelişen teknoloji ile artık Stream, Gerçek Zamanlı raporlama ihtiyacının artmasıdır. Lakehouse ise veri ambarlarında kullanamadığımız gerçek zamanlı akan veriyi, bir araya gelen bu iki dünyada veri göllerinin Real Time yeteneği ile kullanabilir hale getiriyor.

Veri ambarları ve veri gölleri oldukça popüler kavramlar evet, birçok işletmede büyük problemler olmaksızın birlikte de çalışabiliyor evet, ancak veri çözümü olarak iyileştirilmesi gereken yanları da yok diyemeyiz.

O halde sırası gelmişken Data Lakehouse kavramının çözeceği bu problemlerden bazılarını maddelendirelim:

- Veri Duplikasyonu : Şirketlerde birden fazla veri ambarı ve veri gölü olduğunu düşündüğümüzde, proje ihtiyacına göre her sistemde ayrı ayrı oluşan veriler çoklamalara neden oluyor. Verinin merkezi olmamasını, Master Data kavramının oluşmamasını ve tutarlılığın sağlanamamış olmasını bertaraf etsek de maliyet anlamındaki zararı düşünmek dahi istemeyebiliriz.

- Yüksek Depolama Maliyeti: Az önce bahsettiğimiz maliyetin yanında veri ambarı ve veri göllerinde kullanılan farklı teknolojilerin ve altyapı formatlarının maliyeti arttırdığını da söyleyebiliriz. Lakehouse’da ise bu iki sisteme ait teknolojiler birleştiriliyor.

- BI ve Analitik Çalışmalarındaki Kaynak Farklılığı: Analitik ekipler veri göllerinden doğrudan herhangi bir işleme tabi tutulmayan veriler ile çalışırken, BI ekipleri ve hizmet sundukları analiz ekipleri veri ambarlarından işlenmiş ve t-1 veriler ile çalışıyor. Lakehouse ile iki ekibin ortak bir Repository’si oluyor ve çalışmaları birbiri ile örtüşen sonuçlar üretiyor.

Elbette Data Lakehouse kavramı için sorun oluşturabileceği düşünülen konular da var. Örneğin diğer yapılar kadar esnek kullanılıp, konumlandırılamayacağı ya da gerçekten sunması beklenen faydaların tamamının verimli olamayabileceği gibi. Bu problemlerin doğru ihtiyaç ve altyapı analizleri ile minimuma indirilebileceğini düşünüyorum.

İyi, güzel! Lakehouse’ a ikna olduk.

Peki bunu geliştiren veya kullanıma sunmuş olan teknoloji firmaları hangileri?

- Azure Synapse Analytics

- Alibaba Cloud LakeHouse

- Amazon Redshift LakeHouse

- Google Big Query

- Apache Drill

Lakehouse altyapısı deneyimlemek isterseniz 30 gün süre ve Consumption limiti ile Azure Synapse Analytics’e aşağıdaki link üzerinden erişebilirsiniz.

Kaynaklar: